Da circa quattro anni a questa parte, il mio setup astrofotografico risiede stabilmente in un piccolo osservatorio autocostruito, situato nel mio giardino. La struttura, poco più grande di una cuccia per cani con il tetto apribile a libro, mi ha consentito di approfittare di ogni singola ora di cielo sereno per dedicarmi all’astrofotografia deep sky.

Di recente, tuttavia, un cambiamento di necessità ci ha portato a dover cambiare residenza: per qualche tempo quindi dovrò smantellare il mio piccolo osservatorio in attesa di poterlo ricostruire nel giardino della nuova casa. Così mi sono messo a cercare una casa temporanea per il mio fidato setup. Chiedendo un po’ in giro mi sono accorto di come l’hosting di setup privati, in Italia, sia un po’ a livello del paleolitico: là dove, all’estero, troviamo strutture fiorenti che ospitano decine e decine di strumenti controllati in remoto, da noi troviamo…. nulla.

Ma, in mezzo a tutto questo nulla, ho scovato una stella immersa nel buio cielo della Maremma: il Deep Lab di Manciano.

Dopo una breve occhiata ai vari profili social, e alla pagina di Astrobin del gruppo, mi sono deciso a inviare una mail di richiesta informazioni. Non passano dieci minuti che ricevo una cordiale risposta da Giorgio, l’amministratore, che mi lascia il suo numero e mi invita ad una chiacchierata telefonica conoscitiva. Cosa che è avvenuta ben otto minuti dopo. Ormai ero talmente rapito dall’idea di poter fare astrofotografia da un cielo con sqm medio di 21.5 (un Bortle 2-3 per capirsi) che in men che non si dica mi ritrovo con un opzione su una postazione in un osservatorio condiviso, che ospiterà quattro setup e che sarà operativo entro la prossima estate.

Parlando brevemente della struttura, c’è da dire che i ragazzi del Deep Lab sono veramente dei pionieri: il complesso infatti è nato con l’idea di ospitare i loro setup privati da controllare in remoto; poi si sono accorti che la cosa aveva le potenzialità per diventare un business ed hanno ideato gli osservatori condivisi, da affittare annualmente. Il tutto è stato inserito in un bell’agriturismo, con tanto di camere da letto, ristorante e animali al pascolo, per accontentare anche mogli e figli al seguito. Cosa che ha pesato non poco a favore del “SI “.

Avere un setup operante a due ore e mezzo di macchina da casa è però un’impresa non da poco: tutto dovrà infatti essere gestito elettronicamente via PC, non potendo, di fatto, operare fisicamente sull’hardware. Inoltre sarà necessario un “rodaggio” approfondito, in modo da poter identificare eventuali problemi che possono verificarsi, e trovare il sistema di evitarli/gestirli.

Quello che scriverò in queste pagine non è assolutamente da considerarsi un “tutorial”, non avendo di fatto esperienza riguardo all’astrofotografia remota, ma piuttosto una sorta di “blocco note” sul quale butterò giù le mie considerazioni, l’esperienza che maturerò e il problem solving, nella speranza che possa servire a qualcuno. Il tutto sarà aggiornato costantemente, via via che quest’avventura procederà.

Il setup: considerazioni generali e requisiti

Un setup da gestire in remoto deve integrare necessariamente tutte quelle componenti necessarie a compiere, via PC, tutte le azioni che siamo abituati a eseguire manualmente durante una sessione di ripresa: dall’apertura dei tappi delle ottiche, alla ricerca della posizione Home della montatura, fino all’acquisizione dei flats e dei darks di calibrazione.

In linea generale un setup remoto è costituito dalle seguenti componenti:

- Elettronica dell’osservatorio: In questo caso fornita da Deep Lab, consiste in: Switch di accensione/spegnimento setup, azionabile via WIFI; sistema di apertura/chiusura del tetto; stazione meteo; all-sky camera; webcam per visionare in tempo reale il setup.

- Computer di controllo setup: Si può usare un normale laptop (da utilizzare chiuso), un mini-pc oppure un PC specificatamente progettato per l’astrofotografia. Per il collegamento delle periferiche sarà necessario aggiungere un HUB USB 3.0 alimentato, possibilmente che consenta, via software, di resettare singolarmente le varie porte USB ( funzione molto utile in caso di problemi ad una periferica). Cosa fondamentale è l’opzione di poter avviare il computer quando si attiva la corrente dallo switch wifi.

- Hub di alimentazione delle periferiche: consiste in una centralina di distribuzione del 12v, da installare nei pressi del PC, e a cui collegare le varie periferiche: montatura, focheggiatore, camera, flat box ecc. Anche in questo caso, il top è utilizzate un hub con prese gestibili via software in modo da poter alimentare/disalimentare singolarmente le varie utenze.

- Ottica: riguardo all’ottica non vi sono particolari requisiti, si può usare quello che si vuole. Dovrà però avere un focheggiatore di qualità: si sconsigliano i Crayford, che devono essere serrati tramite una vite in modo che il peso del treno di ripresa non li faccia slittare; questa configurazione risente molto della dilatazione termica e pertanto non è adatta a operare in remoto.

- Focheggiatore elettronico: indispensabile.

- Rotatore di campo: facoltativo se si lavora con focali corte e/o con sensori di grandi dimensioni. Diventa invece indispensabile sulle lunghe focali con guida fuori asse, per ricercare una stella di guida.

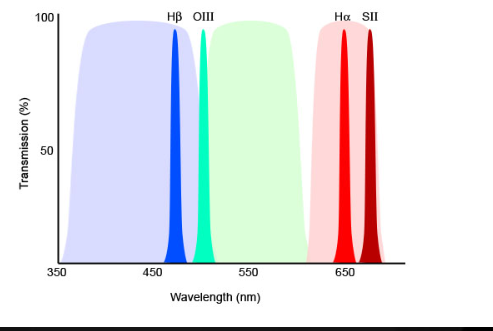

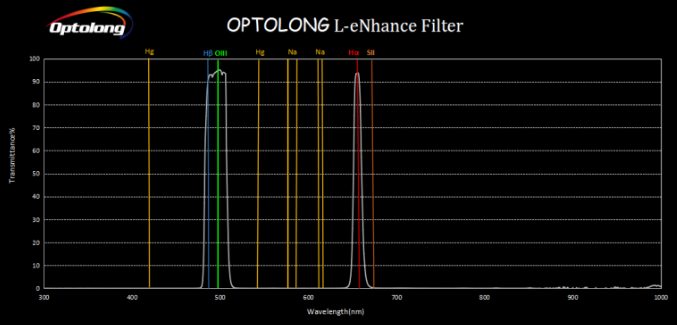

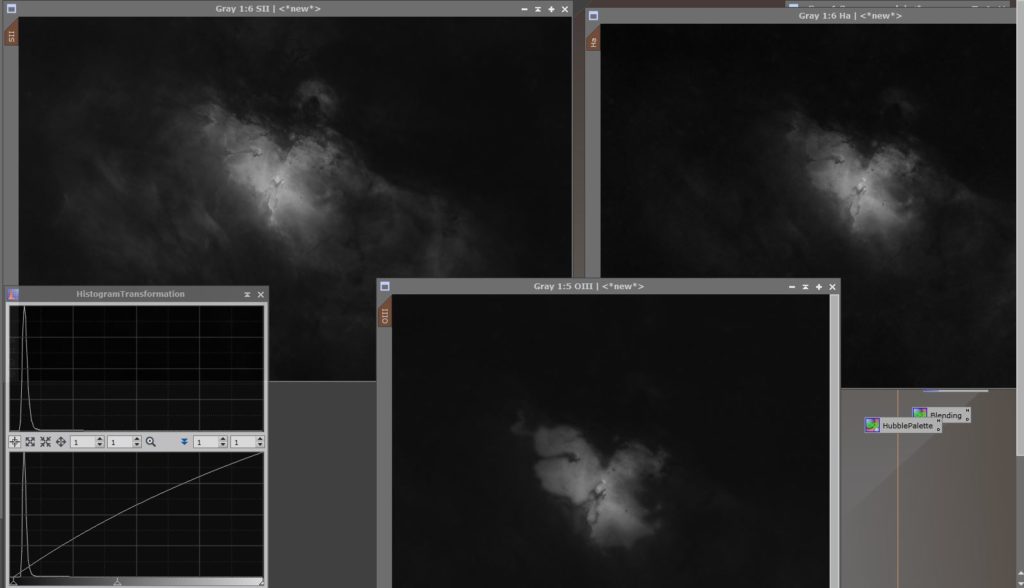

- Camera di acquisizione: Da preferire le camere monocromatiche. Infatti in remoto anche una camera a colori dovrà essere dotata di ruota per filtri, caricata con un filtro LPS per le riprese in banda larga, un filtro multi-banda passante per le riprese in banda stretta ed un filtro nero, costituito anche banalmente da un cartoncino opaco: ci servirà per riprendere dark frames e bias. Con questa premessa si capisce bene come sia più conveniente, oltre che più performante, utilizzare una camera mono.

- Sistema di guida: può essere costituito da un ottica separata munita di camera di guida, oppure da una guida fuori asse, a seconda della focale impiegata. Nel primo caso, da evitare come la peste i piccoli telescopi: un ottica di guida deve essere progettata come tale, e essere munita di focheggiatore elicoidale con sistema di blocco. I focheggiatori tradizionali infatti possono slittare portando fuori fuoco la camera di guida. Altra cosa da evitare sono gli anelli decentrabili tipo cercatore. Oltre a essere la causa principale delle flessioni differenziali, con l’escursione termica le viti possono allentarsi con ovvi risvolti. Tutto sommato, quindi, se si ha dimestichezza con le guide fuori asse queste rappresentano la scelta ideale un po’ per tutte le focali.

- Tappo automatico/flat box automatica: ha la doppia funzione di proteggere le ottiche quando chiuso, fungendo da tappo motorizzato, e permetterci di acquisire i flats. L’interno del tappo è infatti costituito da un pannello led dimmerabile e controllato via USB.

- Gestione delle fasce anti condensa: ogni lente o specchio dovrà avere la sua fascia anti condensa. E dovranno essere gestite da un modulo ambientale in grado di rilevare temperatura, pressione e umidità dell’aria. Non saremo presenti sul posto, e pertanto ci mancherà la nostra percezione.

- Montatura: ho lasciato componente per ultimo perchè sarà il cuore di tutto il setup, e perchè è quello più discusso sui vari forum specifici. Se si guardano video di osservatori remotizzati, cade l’occhio sul fatto che la maggior parte delle montature sono di tipo estremamente avanzato (e costoso): Paramount, Astrophysics, Planewave, l’italiana 10micron e chi più ne ha…più ne spenda. Oltre a guidare con precisioni inferiori a 0.10″, queste montature hanno una caratteristica comune: gli encoders assoluti sugli assi. In pratica sanno sempre esattamente dove sono rivolte. In questo modo la montatura non perde mai la posizione di Home, e sa sempre dove sono i limiti impostati (ad es per non far urtare la camera nel treppiedi, o per non far strappare i cablaggi). Caratteristica alquanto utile se, ammettiamo, salta la corrente all’osservatorio, o se il PC crasha e la montatura continua a guidare oltre il meridiano: a quel punto interviene l’elettronica interna, guidata dagli encoders, e blocca tutto. Alla sessione successiva la montatura riacquisirà la sua posizione di Home e sarà pronta per la sessione in pochi istanti. Un oggetto del genere ha però un costo elevato: si parla di circa diecimila euro per una montatura con carico utile paragonabile a quello di una EQ6. Negli ultimissimi anni, tuttavia, si sono affacciate sul mercato montature prodotte in serie che integrano, sugli assi, dei sensori in grado di rilevarne la posizione con precisione sufficiente a garantire l’operatività in sicurezza delle stesse. Questa funzione si chiama Auto Home e è presente sulle Ioptron dalla CEM 70 in su, sulla EQ8R e sulla CQ350 di Skywatcher, fra le altre. Pur non guidando con la precisione di una montatura con encoders, queste valide alternative “economiche” svolgono egregiamente il loro compito, e permettono di caricare svariate decine di kg di strumenti. Esistono infine rimedi “caserecci”, da applicare alle montature più comuni, per ovviare all’eventuale perdita della posizione Home dovuta a un blackout. Si spazia da micro switch, al controllo tramite webcam dell’allineamento della montatura, a riferimenti disegnati sulla stessa che permettano l’allineamento ecc. Se si opta per queste soluzioni tuttavia c’è sempre da vigilare sul setup mentre opera, perchè il danno può essere da grave a gravissimo in caso di collisioni col treppiedi.

Questi sono i componenti essenziali per riuscire nell’impresa. C’è da dire, a mio vantaggio, che a causa dei miei impegni e della mia quotidianità, con due bambini molto piccoli, ho iniziato già da diverso tempo il processo di automazione della mia attrezzatura: a oggi, infatti, nelle serate limpide le uniche operazioni “manuali” che compio sono l’apertura del tetto della specola, e l’allaccio alla corrente. Quando serve, pongo la flat box sull’ottica. Per il resto gestisco tutto da PC o tablet, mi preparo le sequenze in NINA e mi limito a premere il tasto di avvio: alla mattina, salvo problemi, mi ritrovo la montatura parcheggiata, la camera spenta e i subframes già sull’ hard disk del mio pc di casa. Quindi una buona parte del lavoro è già svolta. Ad ogni modo, una cosa è operare in remoto da trenta metri, che sai che se c’è un problema esci, anche in pigiama, e qualcosa ti inventi. Tutt’altra storia è farlo da 300 km, sapendo che un errore su una sequenza può portare a un mezzo disastro. Il setup che porterò al Deep Lab dovrà quindi essere preparato nel mio attuale osservatorio, e testato a fondo in tutte le sue funzioni e con tutti gli angoli di utilizzo.

In questa prima parte ho cercato di mettere nero su bianco quelli che saranno i requisiti del mio futuro setup. Nella prossima parte, che scriverò quando avrò le idee un po’ più chiare soprattutto sulla scelta della montatura, inizierò a fare una “check list” di quello che ho e di quello che occorrerà.